Las soluciones a todas las variantes de Google Panda que afecta a una Web pasan, generalmente, por eliminar de los índices de Google los contenidos duplicados o escasos. Cualquier otra variante no suele dar resultado estable.

La duplicidad de contenido es frecuente en las Webs y su control, vía canonical, noindex o robots.txt nos evita caer en Google Panda y otros problemas de indexación.

Tengo un post dedicado a las variantes para eliminar el contenido duplicado que puedes leer si tienes dudas al respecto, y también otro dedicado a cómo conocer la indexación de las páginas Web. Te recomiendo que lo consultes si tienes dudas en estos temas.

Sin embargo, en ocasiones, las Webs han generado un contenido duplicado que Google ha indexado y que, por su volumen, han sido penalizados por el buscador.

La única solución a este problema pasa por el borrado de dichos contenidos en los índices de Google y evitar que vuelva a ser indexado o borrándolos de la Web y, obviamente, eliminarlos de los índices.

Veamos un nuevo escenario de una penalización Google Panda y una variante de solución.

Uso del redireccionamiento 301

Existen casos en que las Webs penalizadas por Google Panda han convivido con esta penalización un periodo de tiempo elevado. Son, generalmente, dominios con mediana o elevada autoridad y que, a pesar de sufrir afectaciones en su posicionamiento, mantienen tráfico vía resultados de búsquedas de Google.

Por otro lado parte del contenido duplicado que poseen han recibido enlaces externos de mediana fuerza y ha hecho, en una distorsión de los algoritmos de Google, que dichas páginas de contenidos duplicados tengan un mejor posicionamiento que aquellas con el contenido original de la propia Web.

Ejemplo: Fichas de descripción de productos con menor relevancia que páginas tags con contenidos escasos o duplicados.

Buscando una alternativa para salir de la penalización encontramos una variante, utilizar el redireccionamiento vía 301 de cada una una de las páginas tags hacia la ficha que posee el contenido original. De esta forma buscábamos:

- No perder tráfico por las páginas con contenido duplicado que tenían posicionamiento,

- Reforzar las páginas con el contenido original, y

- Borrar las páginas con contenido duplicado una vez que Google procesara el redireccionamiento.

Redireccionando y comprobando

El sitio Web objeto del trabajo poseía un total de 998,515 páginas de acuerdo a Google Search Console, y se identificaron un total de 200,000 páginas con contenido duplicado. Todas estas se procedieron a a redirigir vía 301.

De estas 200,000 páginas, causa de la penalización de Google Panda, sólo tenían tráfico relevante unas 2,500 páginas; con enlazado externo de autoridad fueron identificadas 40 páginas.

A través de un sistema de procesamiento de ficheros logs fue posible verificar los accesos a las páginas redireccionadas por parte de Googlebot, comprobando el tiempo que le llevaba rastrear los redireccionamientos.

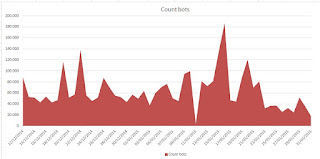

A continuación el gráfico con los accesos de Googlebot a las páginas con contenidos duplicados que fueron redireccionadas:

|

| Accesos de Googlebot a las páginas con contenido duplicadas redireccionadas vía 301 |

Las principales observaciones fueron:

- De acuerdo a los datos los redireccionamientos comenzaron a ser detectados por Googlebot desde el primer día, 12 de Diciembre.

- El procesamiento de todas las páginas redirigidas fue constante hasta el 11 de Enero, practicamente un mes.

- El día 15 de Enero Googlebot hizo un procesamiento de todas las páginas redirigidas y a continuación fue reduciendo el número de solicitudes de las mismas.También comprobamos vía resultados de búsquedas que ya se había realizado el redireccionamiento.

Este movimiento de palabras clave en el índice de Google nos motivo a seguir trabajando lo más rápido posible en la solución del problema con esta nueva aproximación.

Borrado de contenido duplicado

Una vez comprobado que todas las páginas redireccionadas dejaban de estar en el índice de Google comenzamos la eliminación de las páginas duplicadas activándole el código de respuesta 410.

No se borraron y mantuvieron el redireccionamiento aquellas páginas que tenían enlaces externos fuertes.

Sobre el uso del código de respuesta 410 tengo un post dedicado al uso del código de respuesta 410 para contenido borrado, que, en ese caso, demuestra que optimiza el rastreo del Googlebot

A través del Estado de Indexación de Google Search Console comprobamos el borrado de los contenidos eliminando del 8 de Febrero al 22 de Marzo un total de 133,935 páginas con contenido duplicado.

Con estos resultados comenzamos a controlar la evolución en el tráfico tratando de ir incrementando el tráfico de calidad, mayor conversión, y lograr salir de la penalización de Google Panda.

Resultados en Tráfico desde resultados orgánicos de Google

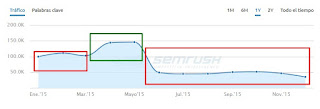

En los meses de Abril y Mayo del 2015 se lograron incrementos de tráfico desde Google, rompiendo la tendencia a la caída de tráfico asociada a Google Panda y, a partir de Diciembre del 2014, a los cambios que se realizaban en la Web.

No obstante estos resultados el cliente decidió abandonar esta opción y volver a restaurar el contenido duplicado, por lo que, nuevamente, las 200,000 páginas con contenido duplicado volvieron a activar en la Web.

Semrush nos pemite observar el comportamiento del tráfico en los momentos de los ajustes, de Diciembre 2014 a Marzo del 2015, los resultados que ya se observaban en Abril y Mayo y la caída posterior al volverse activar el contenido duplicado.

|

| Semrush - Estimación del tráfico del sitio Web objeto de estudio |

Como puede deducirse la nueva entrada del contenido duplicado en los índices de Google provocó una caída rápida de tráfico y la continuidad de Google Panda hasta nuestros días.

Conclusiones

- El redireccionamiento vía 301 de páginas con contenido duplicado hacia aquellas con el contenido original puede ayudar a solucionar el problema del contenido duplicado de este tipo.

- El borrado de páginas Web con código de respuesta 410 optimiza el trabajo de Googlebot y facilita la eliminación del contenido duplicado en Google Index.

- Los resultados que se observaron en el mes de Abril y Mayo eran muy alentadores y pueden dar indicios que la recuperación de Google Panda había comenzando.

- Una vez restaurado el contenido duplicado la caída de tráfico desde Google fue inmediata. A pesar de que, posteriormente, el cliente volvió a eliminar este contenido Google no volvió a restaurar los resultados anteriores.

El cliente que fumaba?? madre de dios! Buen post people!!

ResponderEliminarGracias Dámaso !! aún estamos averiguando lo que fumaba pero no nos queda duda de que fumaba algo, saludos !!

ResponderEliminarEste comentario ha sido eliminado por el autor.

ResponderEliminarBuenas noches, recientemente todos mis blogs han tenido una bajada en las impresiones, algunos casi no están afectados pero otros incluso tuvieron 50% menos de impresiones en Google desde principios de Abril de 2017.

ResponderEliminarEs extraño que esto me pase ya que mis blogs tienen contenidos originales y los actualizo constantemente, así que no entiendo porque hubo esta caída, aparte revise de arriba a abajo la Google Search Console y no encuentro nada inusual así que no me explico que paso.

Debo aclarar que apenas llevo seis meses como blogger pero ya tengo bastantes conocimientos de SEO y se que uno de los factores que afecta un blog es el plagio, pero es raro que mis blog se vean afectados ya que como dije todo es original.

Adrian tu tuviste una bajada en las impresiones que tuvo tu blog en Google durante este ultimo mes? Xq si es así debió haber sido una actualización de panda que afecto a todo el mundo ps.

Hola Leonardo,

EliminarDisculpa la demora, he estado trabajando en varios proyectos y apenas he tenido tiempo de revisar el blog.

Te pregunto, ¿todo tu contenido es original? ¿lo compartes en diferentes blogs de tu propiedad?

Revisa en Google Search Console "Mejoras del HTML" y busca si tienes contenido duplicado dentro de tu propia Web.

Otro posible problema... revisa el robots.txt y comprueba que no has modificado algo en este fichero que haya provocado una mala indexación de Google.

Seguimos en contacto.

saludos y ahora te responderé más rápido ;-)

Buenos días, gracias por tu respuesta revise todo anteriormente y se encuentra en perfecto orden lo que me di cuenta es que las impresiones bajaron a la mitad pero ahora aparezco en mejor posición con respecto al raking, cerre el mes pasado con 50% menos de impresiones en Google pero mi posición media mejoro a 4. Aunque de igual forma si mi contenido es original y no tengo error en el HTML, no me explico porque bajaron ps, sin embargo gracias :)

EliminarRecuerda que el concepto de impresiones no es el mismo que sesiones. Impresiones abarca actividades de bots, herramientas de rastreo que hacen peticiones a google. Es posible que movimientos en el índice donde están tus contenidos hayan dejado de ocurrir y por eso te bajan las impresiones.

EliminarCaídas en demandas de búsquedas se pueden asociar también a las caídas de impresiones. saludos !!