Por todos es conocido el efecto letal para el posicionamiento web poseer contenido duplicado en nuestras Web. Y no se trata ya de que, de una forma deliberada o conocida por los gestores del sitio Web utilicen contenido duplicado.

El problema radica cuando generamos contenido considerado como duplicado por los buscadores por desconocimiento de este problema.

¿Cuáles son las páginas consideradas como duplicadas por Google?

Trataré de resumirlos a continuación:

- Obviamente aquellas páginas que repiten el mismo contenido en diversas URL.

- Páginas con contenidos muy similares y con idénticos títulos, meta descripciones y esquemas de navegación

- Páginas dinámicas que reproducen títulos y resúmenes de otras páginas. Ejemplo clásico: al mostrar el contenido de una taxonomía o clasificación temática de un grupo de páginas Web.

Evitar contenidos duplicados o detectarlos

La forma correcta de lidiar con contenidos duplicados es evitarlos al diseñar el sitio Web mediante una buena organización del contenido, aplicación del meta 'canonical', 'noindex', configuración del robots.txt, etc.

Posteriormente siguiendo una correcta de actualización de la Web que evite duplicar contenido.

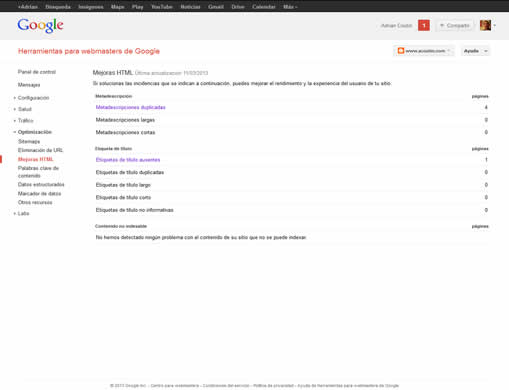

Google Webmaster, entre otras cosas, nos ayuda a conocer el estado de procesamiento de nuestras Web. Algunas de sus opciones nos pueden alertar de la existencia de contenido duplicado en los índices de Google, con la consecuente afectación del posicionamiento web en Google.

La opción Optimización (sombreada en la imagen) nos permite acceder a Mejoras HTML donde podemos conocer la situación de las duplicaciones de metadescripciones y etiquetas de títulos duplicadas.

Una vez detectadas las metadescripciones o títulos duplicados debemos pasar a las acciones que eliminen este contenido, o gestionen la forma de que Google u otro buscador no procese ese contenido.

Si necesitamos duplicar contenidos, por ejemplo, fichas de productos que reproducen el mismo contenido en diversas URL tenemos la opción de usar el meta canonical. Si la web tiene un número elevado de páginas dinámicas que reproducen un mismo meta descriptor debemos seleccionar una como 'landing page' o principal de la sección y cerrar el resto al procesamiento del buscador (aplicar canonical o cerrarlas en el fichero robots.txt ).

¿Es 100% fiable Google Webmaster?

Para sitios pequeños y medianos he comprobado que reporta rápidamente este tipo de problemas.

En sitios Web grandes con un número muy elevado de páginas duplicadas y afectado su posicionamiento no he visto todo el problema completamente reflejado en sus informes; no obstante ayuda a comenzar a detectar la totalidad de la duplicación del contenido.

Si te interesa el tema de contenido duplicado y las penalizaciones de Google puedes leer: Google y el temido índice suplementario (SPI)

También puedes encontrar más detalles en Sobre el uso de esta herramienta para conocer el estado de indexación de tu sitio Web en Google.

Otro tema relacionado con el contenido duplicado y su detección vía Google Webmasters lo toco en

Los errores 404 Leves - No son tan leves

No hay comentarios:

Publicar un comentario